Contribution 세미나

DEFORMABLE DETR: DEFORMABLE TRANSFORMERS FOR END-TO-END OBJECT DETECTION

PaperGPT

2024. 4. 5. 10:35

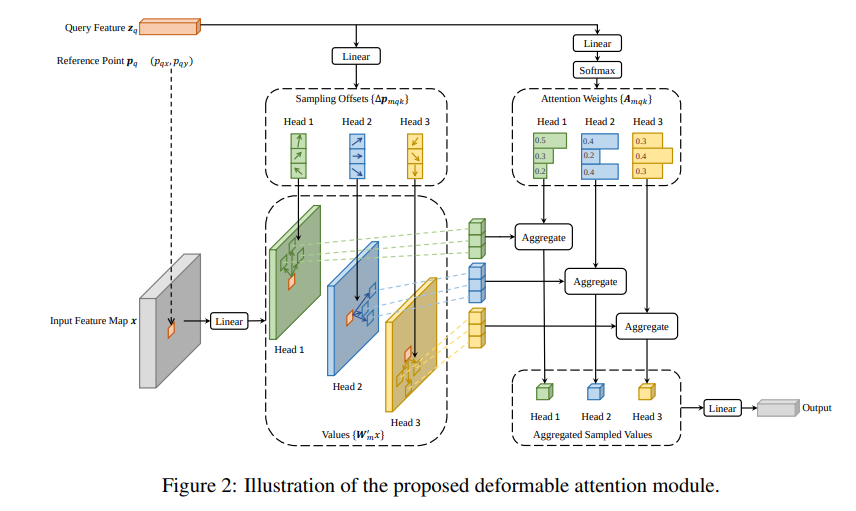

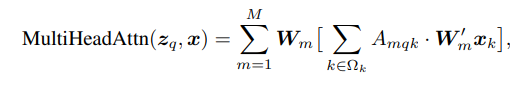

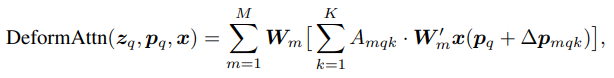

Contribution: Transformer attention module에 deformable 방식 적용

기존 transformer의 문제점

- 학습 수렴속도가 느리다

- 작은 객체 검출이 어렵다

이유

- 초기 attention module은 uniform하게 가중치 부여되어 있어, 특정 영역으로 attention을 주기까지 오랜 학습 시간이 필요함, 개수가 많아질수록 더 심해짐

2. 작은 객체를 검출하기 위해서는 그만큼 image patch size를 줄여야 하는데 연산량이 제곱으로 늘어나서 한계가 있음

핵심

: 그렇다면 우리가 모든 영역을 다 볼 필요가 있을까?

Deformable 연산을 활용하여 초기에 의미있는 image patch들만 골라서 attention에 적용해보자

기존

Deformable

Multi-scale deformable