-

Robust Training under Label Noise by Over-parameterizationContribution 세미나 2024. 4. 18. 12:21

ICML 2022, 66회 인용

Introduction

Sparse over-parameterization (SOP)

best model중 하나

기존의 CE의 경우 noisy label이 있는 경우 noisy data에도 overfitting될 수 있다.

따라서 train accuracy는 증가하더라도 test accuracy는 감소하는 걸 볼 수 있다.

반면에 여기서 제안하는 SOP는 overfitting을 방지 noise에 강인한 성능을 보여줌

본 논문에서는 기존 noisy label를 다루는 방식들과 다르게 loss에 집중함

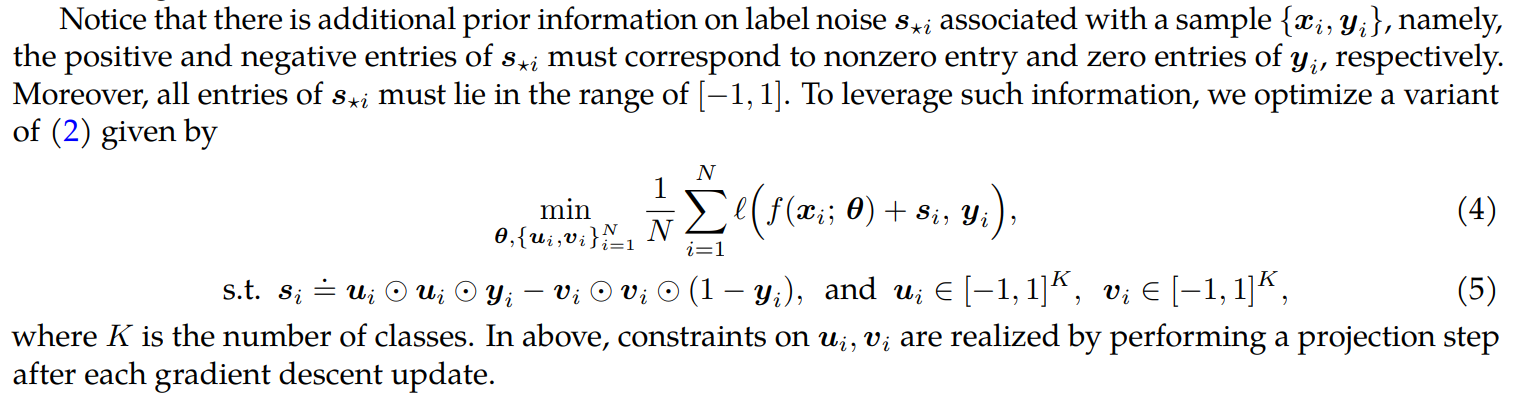

Proposed method

모델 파라미터 이외에도 u, v에 대해서 추가적으로 학습한다.

여기서 u, v는 instance별로 존재하며, 각각 gt label에 대한 가중치와 나머지 class에 대한 가중치를 의미한다.

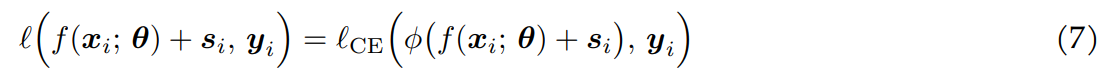

noisy label을 고려한 CE에 대해서 위와 같이 적용한다.

다만 여기서 softmax 대신에 6번식을 사용 (왜그런지는 설명이 없음, 아마 u, v가 -1, 1로 범위가 제한되어 있어 그런듯)

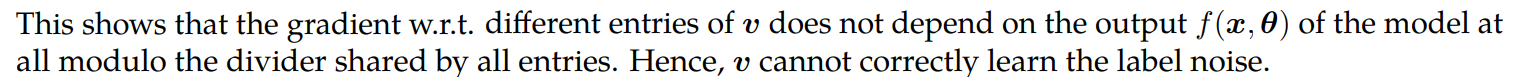

여기서 CE만 사용하게 되면

위 식과 같이 v값의 update가 제한됨, 각각 class별로 업데이트가 되지 않음

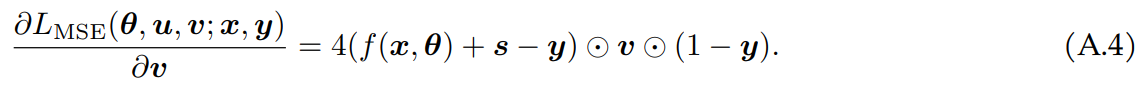

이를 해결하기 위해 v값 업데이트에는 MSE loss 사용

이에 대한 gradient 식은

v를 좀 더 효과적으로 학습 할 수 있음

알고리즘과 같이 모델 파라미터 먼저 학습, 그 이후 u, v 학습을 매 epoch 마다 반복

Experiment result

기존 방식들보다 좋은 성능을 보여줌

여기서 SOP+는 2개의 loss를 추가한 버젼

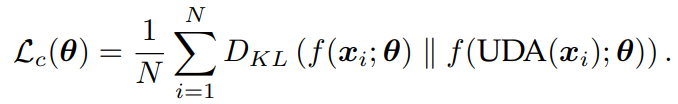

Consistency regularizer

Class-balance regularizer

'Contribution 세미나' 카테고리의 다른 글